A desenvolvedora francesa de IA Mistral AI revelou um novo conjunto de modelos de linguagem projetados para ampliar o acesso à inteligência artificial de ponta, independentemente da localização geográfica, confiabilidade da Internet ou idioma falado. O lançamento inclui modelos de uso geral em grande escala e versões menores e adaptáveis destinadas à implantação em uma variedade de dispositivos.

Expandindo a IA além dos sistemas centrados no inglês

O núcleo do lançamento é o Mistral Large 3, um modelo de alto desempenho competitivo com ofertas da OpenAI e do Google. No entanto, a Mistral distingue-se por priorizar capacidades multilingues. A maioria dos benchmarks de IA existentes são fortemente voltados para o desempenho em inglês, muitas vezes em detrimento da precisão em outros idiomas. A Mistral aumentou deliberadamente a proporção de dados de treinamento em idiomas diferentes do inglês para garantir que seus modelos tenham um desempenho consistentemente bom em todos os idiomas.

De acordo com Guillaume Lample, cofundador da Mistral, muitas empresas evitam focar no suporte multilíngue porque isso pode reduzir ligeiramente as pontuações em benchmarks populares de língua inglesa. Mistral optou por priorizar a usabilidade global em vez das classificações na tabela de classificação. Essa mudança é significativa porque a acessibilidade da IA não se trata apenas de custo; trata-se de equidade linguística.

Modelos menores para aplicações mais amplas

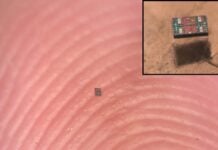

Juntamente com o modelo principal Large 3, a Mistral introduziu a família Ministral 3 : uma gama de modelos menores (3 bilhões, 8 bilhões e 14 bilhões de parâmetros) com variações adaptadas para diferentes casos de uso. Esses modelos menores são projetados para serem eficientes, permitindo que sejam executados em dispositivos como laptops, smartphones, carros e robôs.

As três variações da família Ministral 3 incluem:

- Modelos básicos : personalizáveis pelos usuários para tarefas específicas.

- Modelos ajustados : Otimizados pela Mistral para desempenho geral.

- Modelos de raciocínio : projetados para processamento iterativo para produzir respostas de maior qualidade.

Esta abordagem escalonada reconhece que muitos usuários de IA priorizam funcionalidades especializadas em detrimento do poder bruto de modelos maiores. Ao permitir que os desenvolvedores hospedem esses modelos em seus próprios servidores, a Mistral também aborda preocupações sobre privacidade de dados e custos operacionais.

Funcionalidade Offline e Edge Computing

Uma vantagem importante dos modelos menores é a capacidade de operar offline. Isto é fundamental para aplicações em ambientes onde o acesso confiável à Internet não está disponível, como robótica ou veículos autônomos. A capacidade de executar IA diretamente num dispositivo também aumenta a privacidade, mantendo os dados locais, e reduz o consumo de energia.

“Acreditamos profundamente que isso tornará a IA acessível a todos, basicamente colocará a IA nas mãos deles.” — Guillaume Lample, cofundador da Mistral AI.

A abordagem da Mistral representa um afastamento da tendência de IA centralizada e baseada em nuvem. Ao oferecer modelos abertos que podem ser executados no dispositivo, a empresa está avançando em direção a um ecossistema de IA mais descentralizado e inclusivo.

As implicações mais amplas são claras: a IA está a ultrapassar o controlo de alguns intervenientes importantes em direção a um futuro mais distribuído e acessível. Esta mudança irá provavelmente acelerar a inovação e capacitar os programadores em todo o mundo para criarem soluções de IA adaptadas às suas necessidades e linguagens específicas.