Francuski twórca sztucznej inteligencji Mistral AI zaprezentował nową linię modeli językowych zaprojektowanych w celu zwiększenia dostępu do najnowocześniejszych technologii sztucznej inteligencji, niezależnie od położenia geograficznego, siły połączenia internetowego czy języka. Wydanie obejmuje zarówno wielkoskalowe modele ogólnego przeznaczenia, jak i mniejsze, konfigurowalne wersje, przeznaczone do wdrożenia na różnych urządzeniach.

Rozszerzanie sztucznej inteligencji poza systemy anglocentryczne

Premiera opiera się na Mistral Large 3, modelu o wysokiej wydajności, który jest konkurencyjny w stosunku do ofert OpenAI i Google. Jednak Mistral wyróżnia się tym, że priorytetowo traktuje możliwości wielojęzyczne. Większość istniejących testów porównawczych sztucznej inteligencji jest w dużym stopniu uzależniona od wydajności w języku angielskim, często kosztem dokładności w innych językach. Firma Mistral celowo zwiększyła udział danych szkoleniowych w języku innym niż angielski, aby zapewnić spójne działanie swoich modeli we wszystkich językach.

Według współzałożyciela Mistrala, Guillaume’a Lample’a, wiele firm unika skupiania się na obsłudze wielojęzycznej, ponieważ może to nieznacznie obniżyć wyniki w popularnych anglojęzycznych testach porównawczych. Firma Mistral zdecydowała się przedłożyć globalną użyteczność ponad rankingi. Ta zmiana jest ważna, ponieważ Dostępność sztucznej inteligencji to nie tylko kwestia ceny, ale także kwestia równości językowej.

Małe modele do szerszych zastosowań

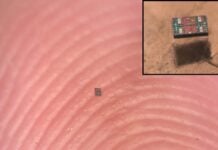

Oprócz flagowego modelu Large 3, Mistral wprowadził rodzinę Ministral 3 : gamę mniejszych modeli (3, 8 i 14 miliardów parametrów) z odmianami dostosowanymi do różnych zastosowań. Te mniejsze modele zaprojektowano z myślą o wydajności, umożliwiając im pracę na urządzeniach takich jak laptopy, smartfony, samochody i roboty.

Trzy warianty rodziny Ministral 3 obejmują:

- Modele podstawowe : Możliwość dostosowania przez użytkowników do konkretnych zastosowań.

- Modele dostrojone : Mistral zoptymalizowany pod kątem ogólnej wydajności.

- Modele rozumowania : Zaprojektowane do iteracyjnego przetwarzania w celu uzyskania lepszych odpowiedzi.

To wielowarstwowe podejście uwzględnia fakt, że wielu użytkowników sztucznej inteligencji przedkłada wyspecjalizowaną funkcjonalność nad surową moc dużych modeli. Dając programistom możliwość hostowania tych modeli na ich własnych serwerach, Mistral rozwiązuje również obawy dotyczące prywatności danych i kosztów operacyjnych.

Funkcjonalność autonomiczna i przetwarzanie brzegowe

Kluczową zaletą mniejszych modeli jest możliwość pracy offline. Ma to kluczowe znaczenie w przypadku zastosowań w środowiskach, w których nie jest dostępny niezawodny dostęp do Internetu, takich jak robotyka lub pojazdy autonomiczne. Możliwość uruchomienia sztucznej inteligencji bezpośrednio na urządzeniu poprawia również prywatność, przechowując dane lokalnie i zmniejszając zużycie energii.

„Głęboko wierzymy, że dzięki temu sztuczna inteligencja stanie się dostępna dla wszystkich, zasadniczo oddając sztuczną inteligencję w ich ręce”. —Guillaume Lampl, współzałożyciel Mistral AI.

Podejście Mistral reprezentuje odejście od trendu w kierunku scentralizowanej sztucznej inteligencji w chmurze. Oferując modele o otwartej wadze, które można uruchomić na urządzeniu, firma zmierza w kierunku bardziej zdecentralizowanego i włączającego ekosystemu sztucznej inteligencji.

Szersze implikacje są jasne: sztuczna inteligencja odchodzi spod kontroli kilku dużych graczy w kierunku bardziej rozproszonej i dostępnej przyszłości. Ta zmiana prawdopodobnie przyspieszy innowacje i umożliwi programistom na całym świecie tworzenie rozwiązań AI dostosowanych do ich konkretnych potrzeb i języków.