Le développeur français d’IA Mistral AI a dévoilé une nouvelle suite de modèles linguistiques conçus pour élargir l’accès à l’intelligence artificielle de pointe, indépendamment de la situation géographique, de la fiabilité d’Internet ou de la langue parlée. La version comprend à la fois des modèles à grande échelle à usage général et des versions plus petites et adaptables destinées à être déployées sur une variété d’appareils.

Étendre l’IA au-delà des systèmes centrés sur l’anglais

Le cœur du lancement est Mistral Large 3, un modèle haute performance compétitif par rapport aux offres d’OpenAI et de Google. Cependant, Mistral se distingue en privilégiant les capacités multilingues. La plupart des références d’IA existantes sont fortement axées sur les performances en anglais, souvent au détriment de la précision dans d’autres langues. Mistral a délibérément augmenté la proportion de données de formation non anglaises pour garantir que ses modèles fonctionnent de manière cohérente dans toutes les langues.

Selon Guillaume Lampe, cofondateur de Mistral, de nombreuses entreprises évitent de se concentrer sur le support multilingue car cela peut légèrement réduire les scores aux tests de référence populaires en langue anglaise. Mistral a choisi de donner la priorité à la convivialité mondiale plutôt qu’au classement. Ce changement est important car l’accessibilité de l’IA n’est pas seulement une question de coût ; c’est une question d’équité linguistique.

Modèles plus petits pour des applications plus larges

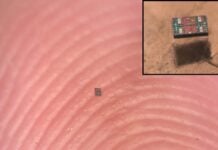

Parallèlement au modèle phare Large 3, Mistral a présenté la famille Ministral 3 : une gamme de modèles plus petits (3 milliards, 8 milliards et 14 milliards de paramètres) avec des variations adaptées à différents cas d’utilisation. Ces modèles plus petits sont conçus pour être efficaces, leur permettant de fonctionner sur des appareils tels que des ordinateurs portables, des smartphones, des voitures et des robots.

Les trois variantes de la famille Ministral 3 comprennent :

- Modèles de base : personnalisables par les utilisateurs pour des tâches spécifiques.

- Modèles affinés : optimisés par Mistral pour les performances générales.

- Modèles de raisonnement : conçus pour un traitement itératif afin d’obtenir des réponses de meilleure qualité.

Cette approche à plusieurs niveaux reconnaît que de nombreux utilisateurs d’IA donnent la priorité aux fonctionnalités spécialisées plutôt qu’à la puissance brute des modèles plus grands. En permettant aux développeurs d’héberger ces modèles sur leurs propres serveurs, Mistral répond également aux préoccupations concernant la confidentialité des données et les coûts opérationnels.

Fonctionnalités hors ligne et Edge Computing

L’un des principaux avantages des modèles plus petits est leur capacité à fonctionner hors ligne. Ceci est essentiel pour les applications dans des environnements où un accès Internet fiable n’est pas disponible, comme la robotique ou les véhicules autonomes. La possibilité d’exécuter l’IA directement sur un appareil améliore également la confidentialité en gardant les données locales et réduit la consommation d’énergie.

“Nous croyons profondément que cela rendra l’IA accessible à tous, en gros, il mettra l’IA entre leurs mains.” — Guillaume Lampe, cofondateur de Mistral AI.

L’approche de Mistral représente une rupture avec la tendance de l’IA centralisée basée sur le cloud. En proposant des modèles ouverts pouvant fonctionner sur l’appareil, la société s’oriente vers un écosystème d’IA plus décentralisé et plus inclusif.

Les implications plus larges sont claires : l’IA échappe au contrôle de quelques acteurs majeurs vers un avenir plus distribué et plus accessible. Ce changement va probablement accélérer l’innovation et permettre aux développeurs du monde entier de créer des solutions d’IA adaptées à leurs besoins et langages spécifiques.